Alter Échos: On oublie parfois que l’IA n’est pas toute jeune. D’ailleurs, dès les années 80, la Belgique faisait figure de précurseur avec la création d’Iridia, le laboratoire de recherche en IA de l’ULB…

Hugues Bersini: Tout à fait, nous avons été parmi les premiers laboratoires d’intelligence artificielle en Europe. Iridia a été créé par un médecin, qui a tout de suite compris le grand potentiel de l’IA dans l’automatisation de processus décisionnels dans le milieu médical. Il ne s’agissait pas de l’IA qu’on connaît aujourd’hui, avec les réseaux de neurones, mais de ce qu’on appelait «l’IA à base de règles», soit l’imitation des processus décisionnels, reproduits sous forme logicielle. On pensait déjà, dans les années 80, qu’on pourrait ainsi remplacer des médecins dans les territoires moins accessibles ou aider des médecins débordés par des processus d’aide à la décision. Au fil des années, certains domaines ont assez rapidement accepté l’IA. C’est le cas de la médecine – il y a déjà beaucoup d’IA dans les hôpitaux belges pour l’aide au diagnostic du cancer, l’aide à la prise en charge du diabète… – mais aussi du secteur bancaire et de l’assurance. Mais il reste encore de nombreux secteurs publics, comme la mobilité, la santé publique, l’emploi, la transition énergétique… qui sont quasi vierges en matière d’IA.

AÉ: Comment l’expliquez-vous?

HB: Il y a de la peur, beaucoup de conservatisme et parfois un manque de compétence. Il y a encore le fantasme de cette IA qui déclasserait, ferait perdre des emplois. Ils préfèrent donc éviter de se lancer dans quelque chose dont ils voient le début, mais pas la fin.

AÉ: Des craintes infondées?

HB: Il y a une diabolisation de ce qu’on fait de l’IA dans la prise de décision; or je pense que son usage est, en général, plutôt bien encadré. Les risques que de nombreux auteurs dénoncent pourraient potentiellement se produire, mais on a beaucoup de garde-fous. On est protégés, notamment par le droit et le RGPD. Les administrations publiques sont extrêmement frileuses, à tort selon moi parce qu’il y a des automatisations, des complémentarités qui leur seraient très bénéfiques, en tout cas dans la vision que je défends d’une IA beaucoup plus ouverte et transparente.

AÉ: C’est cette même vision qui est à l’origine de la création de Fari, l’institut interuniversitaire de l’ULB et de la VUB qui défend une vision de l’intelligence artificielle «pour le bien commun»?

HB: Exactement. Il existe des niches où on pourrait mettre de l’IA, sans remplacer personne, mais en facilitant la prise de décisions. L’idée de la création de FARI m’animait depuis très longtemps. Je constatais que de nombreux instituts d’IA se créaient un peu partout, dans les universités et dans le secteur privé, mais qu’il restait un parent pauvre: les administrations publiques. Et puisque à ce stade on n’arrive pas à les convaincre d’aller plus loin dans l’opérationnalisation de solutions d’IA, on a mis en place des formations et des actions de sensibilisation à destination des responsables informatiques des administrations publiques. Malheureusement aujourd’hui, il n’y a toujours pas une solution d’IA qui soit utilisée dans quelque administration publique bruxelloise que ce soit.

« Au fil des années, certains domaines ont assez rapidement accepté l’IA. C’est le cas de la médecine – il y a déjà beaucoup d’IA dans les hôpitaux belges pour l’aide au diagnostic du cancer, l’aide à la prise en charge du diabète… – mais aussi des bancaires et de l’assurance. Mais il reste encore de nombreux secteurs publics, comme la mobilité, la santé publique, l’emploi, la transition énergétique… qui sont quasi vierges en matière d’IA. »

AÉ: Concrètement, qu’est-ce qu’une IA plus ouverte, plus transparente et agissant pour le bien commun?

HB: Fari promeut une IA dans laquelle les principaux usagers seraient impliqués. On a toujours défendu l’idée qu’il ne faut pas développer des algorithmes ou des logiciels sans se concerter avec ceux qui les utiliseront, de la même manière que dans le privé, on fait beaucoup d’études de marché pour tester la réceptivité des consommateurs à un nouveau produit. Je pense qu’on devrait adopter cette idée-là. Les problématiques de bien commun ne manquent pas. Prenons l’exemple du décret inscription, qui régit l’accès aux écoles – ce n’est pas vraiment de l’IA, mais un logiciel algorithmique: il part d’une assez belle idée, celle de la mixité sociale. Mais dans les faits, c’est tout l’inverse qui se produit: les écoles se sont encore plus «ghettoïsées» ou «embourgeoisées», puisque le premier critère est la proximité géographique, ce qui n’est pas forcément la meilleure idée si on veut favoriser la mixité. Grâce à l’IA, cela aurait pu être anticipé en faisant des simulations: si vous considérez que la localité est le premier critère, et compte tenu de la distribution de l’habitat dans ce quartier, voilà ce qui risque de se produire dans les écoles…

AÉ: L’apparition de ChatGPT a récemment propulsé l’IA dans la sphère individuelle, accessible à portée de clic. C’est un vrai tournant dans l’histoire de l’IA?

HB: Oui, assurément. Ça a pris tout le monde par surprise. Il y a eu un premier choc en 2014-2015, avec l’image: jusque-là, les réseaux de neurones ne parvenaient pas très bien à extraire les caractéristiques d’une image – par exemple, reconnaître un visage ou un objet sur une photo – et l’intervention humaine restait essentielle. Puis, avec le développement du «deep-learning» (l’apprentissage profond, rendu possible par des réseaux de neurones de plus en plus complexes) et le nombre grandissant d’images disponibles via les réseaux sociaux, les réseaux de neurones ont commencé à être plus efficaces si l’humain leur laissait une totale autonomie. Ça a été, en quelque sorte, un coup porté à l’orgueil des informaticiens.

Mais le gros choc, ça a été le langage. On a toujours cru que la seule IA qui parviendrait à générer du texte serait l’IA symbolique, c’est-à-dire l’IA à base de règles, à qui il faudrait traduire en codes les règles de syntaxe ou de sémantique. Fin 2017, une étude publiée chez Google annonce qu’un certain type de réseaux de neurones, en prédisant le prochain mot dans un texte, allait apprendre à parler. En 2022, Sam Altman comprend qu’il y a quelque chose de potentiellement fort dans cette idée-là et sort ChatGPT. En quelques mois, des centaines de millions de personnes ont testé l’outil. Et aujourd’hui, il y a des centaines, voire des milliers de différents modèles de langage.

AÉ: Parvient-on encore à comprendre comment l’IA comprend?

HB: De plus en plus difficilement. L’utilisation du mot «comprendre» pose problème aux linguistes et aux philosophes, mais personnellement je n’ai pas de gêne à l’utiliser. Parce que je pense que l’IA comprend. Pour pouvoir créer un roman policier, il doit y avoir quelque part la maîtrise d’un concept. Ce ne sont pas que des répétitions stochastiques (aléatoires, basés sur la conjecture). L’IA est devenue l’un des meilleurs programmeurs qui soient. Dans les olympiades de mathématiques, elle est aujourd’hui dans le top 3 des meilleurs mathématiciens de la planète. Elle ne pourrait pas y arriver si elle ne comprenait pas quelques concepts de base.

AÉ: Votre discours sur l’IA se veut rassurant. Avez-vous néanmoins des sources d’inquiétude?

HB: C’est assez difficile de se positionner sur le type de craintes à avoir parce que les meilleurs experts ne sont absolument pas d’accord entre eux. Tout le monde s’aligne sur une chose cela dit: les manipulations très dangereuses qui peuvent être faites de ces logiciels, comme les hypertrucages (deepfakes). Ce pouvoir de manipulation de la vérité est très troublant et il y a de vrais risques. Ce ne sont pas des risques de fin du monde, mais quand vous voyez Donald Trump entouré de tous les géants de la tech, c’est une coalition assez effrayante de l’autocratie et de la technocratie.

« Quand vous voyez Donald Trump entouré de tous les géants de la tech, c’est une coalition assez effrayante de l’autocratie et de la technocratie. »

Il y a aussi des inquiétudes plus profondes, presque existentielles, que soulignent certains, parmi lesquels des créateurs les plus importants de l’IA – comme les Prix Nobel de physique Geoffrey Hinton et John Hopfield: l’IA pourrait elle-même décider de certaines stratégies pour atteindre l’objectif qu’on lui a confié, stratégies qui n’auraient pas été anticipées et qui pourraient nous nuire. Exemple: on demande à l’IA d’optimiser une production nécessitant une puissance électrique importante. Comme tout est informatisé aujourd’hui, y compris les centrales électriques et les hôpitaux, elle pourrait par exemple court-circuiter des générateurs d’énergie dans des hôpitaux ou bloquer les transports, parce qu’elle a besoin de toute l’électricité nécessaire pour accomplir sa tâche. Elle ne le ferait pas sciemment pour mettre des vies en danger, mais elle déploierait toutes les stratégies en son pouvoir pour atteindre l’objectif qu’on lui a confié, quitte à nous nuire. Et comme on met de l’IA dans des secteurs de plus en plus sensibles, comme les voitures autonomes, la défense avec les drones… C’est une réelle crainte.

AÉ: Quelle réponse apporter face à ces dangers?

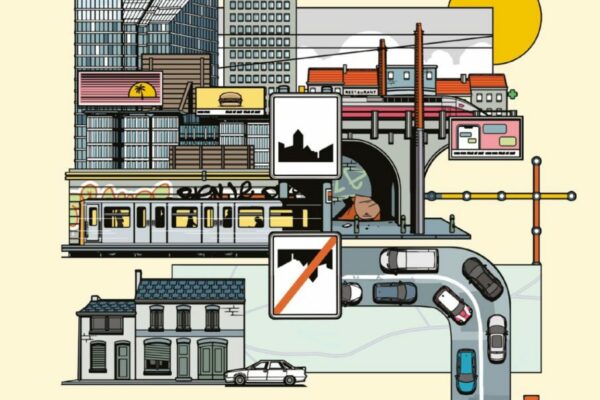

HB: Il serait nécessaire de réinventer le régime politique, en instaurant beaucoup plus de démocratie participative. Nous avons perdu le contrôle de nos biens publics. Prenez la mobilité: c’est quand même étrange qu’on ait confié à Waze la circulation dans nos villes. Les usagers devraient avoir leur mot à dire, il faut leur donner plus de poids pour qu’ils comprennent à quelle sauce ils risquent d’être mangés, qu’ils participent à l’élaboration de ces algorithmes, mais aussi qu’ils comprennent en quoi ça peut leur être très bénéfique.

Le public doit se saisir de l’IA pour ne pas la laisser aux mains du privé. Les solutions déployées actuellement sont d’une telle efficacité que je ne serais pas étonné que dans quelques années ce soit l’algorithme de Google qui décide dans quelle école iront vos enfants…

AÉ: Selon vous, l’IA amplifie-t-elle les inégalités, en créant une nouvelle élite qui maîtrise ses outils, ou au contraire peut-elle redistribuer les cartes, en «démocratisant» certaines compétences?

HB: Là aussi, c’est extrêmement compliqué. Prenez ChatGPT dans le contexte universitaire: tous les étudiants l’utilisent, mais tous n’ont pas la même version et tous ne l’utilisent pas de la même façon. Certains en font un usage plus intelligent que d’autres, mais le fait même qu’ils l’utilisent signifie qu’ils empruntent des raccourcis sur beaucoup de processus d’assimilation des connaissances. Actuellement, on est dans cette phase où l’on essaie de comprendre l’impact de ChatGPT sur les étudiants et sur le fonctionnement de l’université. On devrait bientôt pouvoir observer si cela crée des inégalités.

« Les usagers devraient avoir leur mot à dire, il faut leur donner plus de poids pour qu’ils comprennent à quelle sauce ils risquent d’être mangés, qu’ils participent à l’élaboration de ces algorithmes mais aussi qu’ils comprennent en quoi ça peut leur être très bénéfique. »

Pendant longtemps, on a cru que les cols bleus (la classe ouvrière, NDLR) seraient davantage protégés que les cols blancs (les cadres et élites, NDLR); mais certains disent que ce n’est même plus vrai, parce que d’ici quelques années les robots pourraient s’améliorer, comme ChatGPT. On vit actuellement un tsunami avec ces nouveaux outils, et on est pris de court. On dit tout et son contraire: certains auteurs disent que l’IA va accroître les inégalités intellectuelles entre ceux qui comprennent et maîtrisent ces outils et les autres. Au niveau professionnel aussi, c’est un grand débat: est-ce que cela va faire disparaître des emplois, créer des inégalités ou être un niveleur, par le bas ou par le haut? On n’a pas encore assez de recul pour le dire.

AÉ: Se pose aussi la question de la finitude. Les potentialités de l’IA semblent infinies, alors qu’on vit dans un monde aux ressources finies. Et l’impact environnemental de l’IA est considérable…

HB: C’est un autre problème. La consommation énergétique de ces nouveaux outils est effrayante. Mais comment freiner les GAFAM qui achètent des centrales nucléaires à tour de bras? Ma position à ce sujet, que je développe dans un livre qui vient de paraître aux PUF (Pour un compte carbone individuel, 2025, PUF), est un peu radicale: il s’agirait d’informer les citoyens en temps réel de leur consommation de CO2 (déplacements, usages domestiques, etc.), jusqu’au stade où on pourrait limiter celle-ci. Imaginons que vous fassiez une recherche sur ChatGPT, votre compte carbone diminuera. Ce ne serait pas facile à mettre en place, mais l’IA pourrait justement nous aider à l’anticiper.

La courbe exponentielle de ces nouveaux outils algorithmiques en matière de consommation énergétique est proprement affolante. On pense que si ça continue comme ça, d’ici quelques années, 30 à 40% du CO2 émis sera dû à l’utilisation de nos outils numériques.